پردازش موازي

تعریف

یک سیستم محاسبات موازی رایانه ایست با بیش از یک پردازنده که برای پردازش موازی استفاده میشود. در گذشته، در یک سیستم چندپردازنده هر پردازنده در یک بستهبندی جداگانه قرار داشت، اما امروزه با معرفی تراشههای چندهستهای، چندین پردازنده در کنار یکدیگر در یک بسته قرار میگیرند. در حال حاضر انواع بسیار گوناگونی از رایانههای موازی وجود دارند که بر اساس نوع اتصالات بین پردازندهها و حافظه از یکدیگر متمایز میشوند. ردهبندی Flynn که یکی از پذیرفتهشدهترین ردهبندیها برای رایانههای موازی است، رایانههای موازی را بر این اساس طبقهبندی میکند که آیا شامل پردازندههایی هستند که همگی همزمان یک دستور یکسان را روی دادههای متفاوتی اجرا میکنند (یک دستور چند داده SIMD: Single Instruction Multiple Data) و یا هر پردازنده دستور متفاوتی را روی دادههایی متفاوت اجرا میکند (چند دستور چند داده MIMD: Multiple Instruction Multiple Data).

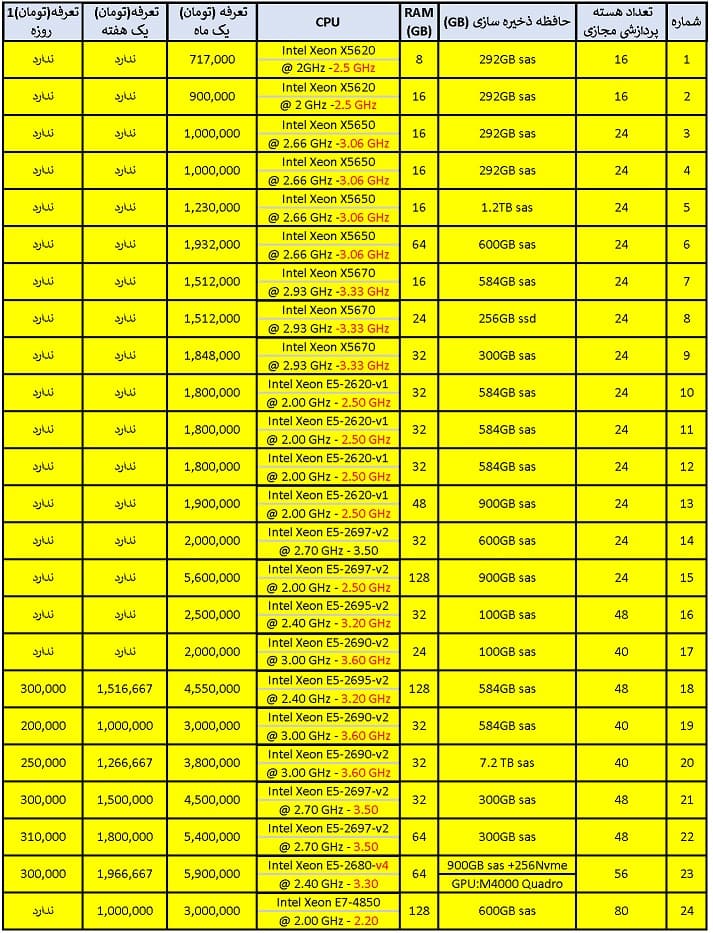

← اجاره ابر رایانه →

تفاوت پردازش موازی با پردازش همروندی و چندکارگی

مفهوم همروندی به معنی این است که چند عمل وجود دارند و آنها به طور همزمان باهم درحال اجرا هستند و میتوان وقفه ای در یک عمل صورت بگیرد و به طور کلی عمل متوقف شود.همروندی در علوم رایانه در سامانههایی پیش میآید که در آنها چند پردازش محاسباتی همزمان اجرا میشوند و با یکدیگر اندرکنش دارند (ناحیه بحرانی دارند). مطالعه همروندی محدوده وسیعی از سامانهها را دربرمیگیرد، از سامانههای رایانش موازی سخت-درگیر و بسیار همزمان گرفته تا سامانههای توزیعشده ناهمزمان سست-درگیر. حال آنکه در پردازش موازی ، عمل اصلی وقتی به چند عمل کوچک تر تقسیم میشود ، این عمل ها میتوانند از هم مستقل باشند.به عنوان مثال اگر دو نخ یا دو پردازه همزمان درحال اجرا روی یک هسته پردازنده باشند، این مفهوم همروندی ست اما اگر دو نخ یا دو پردازه همزمان درحال اجرا روی دو هسته پردازنده باشند، این مفهوم موازیست.

چندکارگی یا چندوظیفگی اجرای همزمان دو یا چند کار و وظیفهٔ رایانهای از سوی واحد پردازش مرکزی است.

مراحل کار به صورت زیر میباشد: ۱- پردازنده یک سیگنال وقفه دریافت مینماید. ۲- پس از دریافت سیگنال وقفه توسط پردازنده، پردازنده کاری را که در حال انجامش است را متوقف نموده و تا آن نقطهای که آن کار را انجام داده ذخیره مینماید تا در زمان مقتضی به ادامه کار قبلی از همان نقطه توقف یافته بازگردد. ۳- پردازنده به سراغ دستگاه یا برنامه درخواست کننده وقفه رفته و دستور را برای پردازش فراخوانی مینماید. ۴- بعد از پردازش یک دستور از مرحله قبل، وقفه برای زمانبندی فراخوان میدهد

پردازش موازی

پردازش موازی اجرای یک فرایند به طور همزمان، عموماً با تقسیم عملیات پردازش بر روی چندین پردازنده به منظور افزایش کارایی و در نهایت سرعت بخشیدن برای رسیدن به جواب است. گاهی استفاده از تکنیکهای اشتراک زمان را در یک پردازنده، به اشتباه پردازش موازی به حساب میآورند (چند پروسه به طور موازی روی یک پردازنده اجرا میشوند). ایدهٔ این کار بر این مبنا است که هر مسئله به طور معمول قابل تقسیم به چندین مسئله با اندازهٔ کوچکتر است که این مسئلههای کوچکتر میتوانند به صورت همزمان حل شده و در نهایت ادغام شوند تا نتیجه نهایی سریعتر بدست آید.

کاهش زمان محاسبه، امکان حل مسایل بزرگتر، غلبه بر محدودیتهای حافظه، صرفه اقتصادی و استفاده از فناوریهای روز از جمله برتریهایی است که برای پردازش موازی نسبت به پردازش سریال (روش سنتی تر پردازش اطلاعات) برشمرده میشود.

مزایای استفاده از پردازش موازی

مزایای سیستمهای ابررایانه را که عامل اصلی رشد سریع آنها نیز میباشد میتوان به شرح زیر لیست نمود.

- نسبت هزینه بهکارایی بسیار پایین

- سختافزار و نرمافزار ارزان و در دسترس

- تعمیر و نگهداری ساده

- قابلیت توسعه سیستم متناسب با افزایش نیاز

- امکان بهروزرسانی سیستم

- زمان بالای در اختیار بودن و سرویسدهی سیستم

- کاهش زمان اجرا در شبیه سازی ها و حل مسائل کاربردی

- گسترش دامنه تحقیقات

- امکان حل مسائل بزرگتر و پیچیدهتر

- استفاده از IO (سیستم های ورودی و خروجی) در بسیاری از ماشین آلات (مثل پایگاه داده های توزیعی).

برنامهنویسی موازی

برنامهنویسی موازی (به انگلیسی: Parallel Programming) برای استفاده هر چه بهتر از منابع سیستم و افزایش سرعت و کارایی برنامه روی پردازندهها به وجود آمد. در این نوع برنامهنویسی، قسمتهایی از برنامه اصلی که قابلیت اجرای همزمان (به انگلیسی: Concurrent) را دارند به چند زیربرنامه تقسیم شده و به صورت همزمان روی چند پردازنده یا چند نخ (en:Thread) اجرا میشوند. قسمتی از برنامه هم که قابلیت اجرای موازی (به انگلیسی: Parallel) را ندارد به صورت سریال روی یک پردازنده اجرا میشود. در واقع تفاوت اصلی برنامهسازی ترتیبی و موازی همین امر میباشد، اما در پی آن مفاهیم متعددی مطرح میشود که اغلب در برنامهنویسی معمولی مطرح نبوده و یا ماهیت آنها با مفهوم متناظر آن در برنامهنویسی معمولی کاملاً متفاوت است.

یکی از دلایل اصلی استفاده از برنامهنویسی موازی، بحث افزایش سرعت اجرای برنامه میباشد، که این امر در پردازندههای تک هستهای دارای محدودیتهای زیر میباشد:

- افزایش تعداد ترانزیستورهای پردازنده برای بدست آوردن سرعت بیشتر، باعث افزایش توان مصرفی خواهد شد که اگر تعداد این ترانزیستورها زیاد باشد، گرمای ایجاد شده ناشی از توان مصرفی پردازنده باعث ذوب شدن آن خواهد شد.

- باید به این نکته توجه داشت که اگر پردازندهها بسیار قوی باشند، به دلیل اینکه هر دسترسی به حافظه به چندین کلاک پردازنده نیاز دارد، محدودیت سرعت دسترسی به حافظه باعث خواهد شد پردازنده زمانی را برای نوشتن در یا خواندن از حافظه منتظر بماند و در نتیجه از تمام توان مصرفی آن استفاده نشود.

تاریخچه

دهه ۱۹۵۰

ایده استفاده از موازی سازی چنددستور، چندداده (به انگلیسی: Multiple Instruction, Multiple Data) یا به اختصار (en:MIMD) به سال ۱۹۵۴ بر میگردد، جایی که اولین کامپیوتر تجاری محاسبات اعداد ممیز شناور توسط جن آمدال در شرکت آی بی ام با نام ۷۰۴ تولید شد. در آوریل ۱۹۵۸ اس. جیل (فرانتی)، بحث انشعاب و انتظار را در برنامهنویسی موازی مطرح کرد. همچنین در همین سال دو تن از محققان شرکت آی بی ام به نامهای جان کوک و دنییل اسلوتنیک، ایده استفاده از موازی سازی در محاسبات عددی را برای اولین بار مطرح کردند.

دهه ۱۹۶۰

در سال ۱۹۶۲ شرکت باروز، کامپیوتر دی ۸۲۵ که دارای ۴ پردازنده و توانایی دسترسی به ۱۶ ماژول حافظه از طریق سوییچ چلیپایی بود را معرفی کرد. در سال ۱۹۶۷، آمدال و اسلوتنیک در کنفرانس پردازش اطلاعات در آمریکا، قانون آمدال را معرفی کردند که محدودیت افزایش سرعت در برابر موازی سازی را مطرح میکند. در سال ۱۹۶۹ شرکت هانی ول، سیستم چندپردازندهای را معرفی کرد که دارای ۸ پردازنده به صورت موازی بود.

دهه ۱۹۸۰

اولین کامپیوتر مدرن یک دستور، چند داده (به انگلیسی: Single Instruction, Multiple Data) یا به اختصار (en:SIMD) در سال ۱۹۸۷ با نام ماشین متفکر توسط دنی هیلز و شرلی هندلر بازسازی شد.

دهه ۱۹۹۰

در دهه ۹۰ تولید کامپیوترهای یک دستور، چندداده روند رو به رشدی پیدا کردند، در سال ۱۹۹۵ شرکت سانمیکروسیستم UltraSPARC را معرفی کرد. همچنین شرکت اینتل در سال ۱۹۹۶ اولین کامپیوتر رو میزی دارای سیستم یکدستور، چندداده برای سیستمهای ۳۲ بیتی معرفی کرد. در سال ۱۹۹۶ استاندارد (en:POSIX Threads) برای برنامهنویسی چند نخی معرفی شد. همچنین در این دهه معماری (en:OpenMP) در سال ۱۹۹۷ برای برنامه نویسی سیستمهای موازی با زبان فرترن معرفی گردید، و در سال ۱۹۹۸ نیز نسخه C/C++ این معماری معرفی شد.

سال ۲۰۰۰ تا کنون

از سال ۲۰۰۰ تا کنون نسخههای بهبود یافتهای از OpenMP ارائه شده است. در سال ۲۰۰۰ نسخه ۲٫۰ فرترن و در سال ۲۰۰۲ نسخه ۲٫۰ سی پلاس پلاس OpenMP ارائه شد. نسخه ۲٫۵ در سال ۲۰۰۵ و نسخه ۳٫۰ در سال ۲۰۰۸ ارائه شد. نسخه ۴٫۰ برنامه در سال ۲۰۱۲ ارائه شد.

ارتباط بین پردازش ها

پردازشها (به انگلیسی: Process) در برنامهنویسی موازی برای انجام محاسبات خود نیاز به برقراری ارتباط با یکدیگر دارند، که روشهای زیر برای این کار میباشند:

- حافظه اشتراکی (en: Shared Memory)

- تبادل پیام (en: Message Passing)

- مدل ضمنی (به انگلیسی: Implicit)

حافظه اشتراکی

در حافظه اشتراکی، وظایف (به انگلیسی: Task) موازی برای برقراری ارتباط با یکدیگر از یک فضای آدرس اشتراکی که توانایی نوشتن و خواندن غیرهمزمان (به انگلیسی: asynchronous) را دارد استفاده میکنند. در این حالت برای کنترل دسترسیهای همزمان (به انگلیسی: synchronous) وظایف به این آدرسها نیاز به مکانیزمهایی مانند قفلها، سمافورها و مانیتورها میباشد.

تبادل پیام

در این روش، وظایف موازی دادههای مورد نیاز را از طریق پیام برای یکدیگر ارسال میکنند، که این ارتباطات میتوانند همزمان یا غیرهمزمان باشند. در روش غیرهمزمان فرستنده پیام خود را بدون توجه به آمادگی گیرنده ارسال میکند.

مدل ضمنی

در این مدل، ارتباط بین وظایف بدون دخالت برنامهنویس انجام میشود. به این صورت که کامپایلر این کار را انجام میدهد.

اصول برنامه نویسی موازی

یافتن موازات کافی در برنامه(قانون آمدال)

طبق قانون آمدال در برنامهنویسی موازی، باید طوری برنامه را به دو قسمت موازی و سریال تقسیم کرد، که مقدار سرباری (به انگلیسی: Overhead) که به سیستم به دلیل تقسیم وظایف میان نخها/پردازندهها تحمیل میشود از مقدار سودی که بدلیل موازی کردن برنامه بدست میآوریم کمتر باشد.

دانه دانه کردن

هنگام تقسیم وظایف، باید به اندازه قسمتی از برنامه که قرار است به صورت موازی اجرا شود توجه داشت. به این صورت که در صورت زیاد بودن تعداد آنها و کوچک بودن این قسمتها سربار بسیار زیادی به سیستم تحمیل خواهد شد، و در صورتی که اندازه این قسمتها بسیار بزرگ باشد، در آن صورت این قسمتها تقریباً به صورت سریال اجرا میشود که افزایش سرعتی در این حالت نخواهیم داشت.

محلی سازی

سرعت دسترسی به حافظههای دارای حجم بالا کم بوده، و سرعت دسترسی به حافظههای دارای حجم پایین زیاد میباشد. با توجه به این امر، برنامهنویس باید طوری عمل کند که الگوریتمهای موجود در برنامه باید بیشتر کار خود را روی دادههای موجود در حافظه محلی (به انگلیسی: Local Memory) انجام دهند.

عدم تعادل بار

عدم تعادل بار (به انگلیسی: Load Imbalance) به حالتی گفته میشود که در آن بعضی از پردازندهها در برخی زمانها به دلایل زیر کاری را انجام نمیدهند:

- موزات ناکافی.

- وظایف غیرهماندازه.

تعادل بار به دو صورت ایستا (به انگلیسی: Static)، یا پویا (به انگلیسی: Dynamic) در زمان اجرا انجام میپذیرد.

همگام سازی

بسیاری از الگوریتمهایی که برای اجرای موازی فرمانهای، موازیسازی میشوند، الگوریتمهایی هستند که پردازشهای موازی حاصل از آنها بدون نیاز به ارتباط با دیگر پردازشها، به محاسبات خود پرداخته و آن را ادامه میدهند. اما الگوریتمهای دیگری نیز وجود دارند که در آنها هر پردازنده محاسبات تکراری یکسانی را روی یک جزء متمایز دادهای انجام میدهد، اما پردازندهها باید در انتهای هر تکرار با یکدیگر همگام (به انگلیسی: Sync) شوند و نتایج میانی خود را در اختیار دیگر پردازندهها قرار دهند. یک روش مورد استفاده برای همگامسازی استفاده از حصاربند (به انگلیسی: Barrier) است که در این روش پردازشهای اولیه که دستورالعمل حصاربندی را اجرا میکنند تا زمانی که تمام پردازشهای دیگر وارد این نقطه شوند، در انتظار باقی میمانند.

شرایط مسابقه

شرایط مسابقه (به انگلیسی: Race Condition) یکی از خطاهای رایج در برنامه نویسی موازی به دلیل دسترسی همزمان وظایف به منابع میباشد که این خطاها به صورت غیرقطعی بوده (به انگلیسی: non-deterministic) و لذا تشخیص آنها سخت میباشد. برای جلوگیری از به وجود آمدن این شرایط میتوان از قفلهای سختافزاری یا نرمافزاری استفاده کرد.

ابزارهای برنامه نویسی موازی

با استفاده از ابزارها، برنامهنویس میتواند خود به طراحی روند اجرای موازی برنامه بپردازد و برای اموری مانند متغیرهای اشتراکی، وابستگی ورودی و خروجی رشتههای موازی، ارتباط میان رشتههای پردازشی یا پردازهها و تجزیهپذیری بنیادی راهحل مسئله مورد نظر تصمیم بگیرد و شیوه توزیع شدن محاسبه، متغیرها و اشیا را طراحی کند. این دسته ابزارها خود به دو گروه عمده تقسیم میشوند:

- ابزارهای برنامهسازی برای سیستمهای دارای حافظه اشتراکی

- ابزارهای برنامهنویسی برای سیستمهای دارای حافظه توزیعشده (en: Distributed Memory).

ابزارهای برنامه نویسی حافظه اشتراکی

POSIX Threads

مجموعهای از کتابخانههای استاندارد به زبان C، که دارای توابعی برای برنامهنویسی موازی چندنخی میباشد و معمولاً با عنوان Pthreads شناخته میشود. در Pthreads نخها از یک فضای آدرس دهی مشترک استفاده میکنند که کنترل و همگامسازی دسترسی نخها به این حافظه بر عهده برنامه نویس میباشد. همچنین هر نخ فضای آدرس مخصوص به خود را دارد. Pthreads برای برنامههای که دارای ویژگیهای زیر هستند، میتواند مناسب باشد:

- چند وظیفه به صورت همزمان، قابلیت اجرای پردازش روی دادههای برنامه را داشته باشند.

- قطعههای از برنامه که زمان زیادی را منتظر ورودی/خروجی میمانند.

- برنامههایی که در آنها برخی کارها نسبت به بقیه دارای اولویت باشد.(وقفههای اولویت)

دلایل استفاده از Pthreads

- Pthreads، هنگام اجرای برنامه کار پردازنده را با کار ورودی/خروجی همپوشانی میسازد.

- نخها با سربار بسیار کمتری نسبت به پردازشها در سیستم ایجاد میشوند.

- تمام نخها در داخل یک پردازش، از یک فضای آدرس اشتراکی استفاده میکنند.

OpenMP(open multi-processing)

OpenMP یک واسط برنامه نویسی کاربردی (en: API) برای برنامهنویسی موازی رشتهها در سیستمهای حافظه اشتراکی با یکی از سه زبان C، C++ یا فورترن است و از معماریهای مختلفی از جمله پلتفرمهای ویندوز و یونیکس پشتیبانی میکند. البته تولیدکنندگان کامپایلر برای زبانهای دیگر از جمله جاوا نیز امکان نوشتن برنامه با رابط OpenMP رافراهم کردهاند. باید توجه داشت، OpenMP تضمین نمیکند که از حافظه اشتراکی استفاده بهینه خواهد کرد. همچنین مواردی مانند وابستگی دادهها، شرایط مسابقه یا بنبستها(به انگلیسی: deadlock) باید توسط خود برنامه نویس در کد برنامه کنترل شود وOpenMP عموماً نمیتواند کاری درباره آنها انجام دهد. همزمان سازی ورودی و خروجی هنگام دسترسی موازی و چک کردن ترتیب اجرای کد برنامه نیز از جمله وظایف برنامه نویس است و از عهده OpenMP خارج است. بهاین ترتیب، برنامهنویس باید ساختار کد و الگوریتم خود را کاملاً کنترل کرده و اطمینان حاصل کند که موارد ذکر شده در اجرای برنامه رخ نخواهد داد.

دلایل و مزایای استفاده از OpenMP

- سختی استفاده از کتابخانههای مربوط به نخها، رابطهایی (به انگلیسی: Interface) مانند Pthreads دارای تعداد زیادی فراخوانی کتابخانهای (به انگلیسی: Library Call) برای مقدار دهی اولیه(به انگلیسی: Initialization)، همگام سازی، ساخت نخ و دیگر کارها دارند.

- سادگی انجام موازیسازی برنامه سریال با برچسب زنی(به انگلیسی: Annotation) کد برنامه که موازات را نشان میدهد.

- مقیاس پذیری (به انگلیسی: Scalibility) و کارایی خوب در صورت استفاده صحیح.

- قابل حمل بودن(به انگلیسی: Portable) برنامه نوشته شده با OpenMP، به دلیل پشتیبانی بسیاری از کامپایلرها از OpenMP.

- عدم نیاز به برنامه نویسیهای پیچیده توسط برنامه نویس.

- اجرا شدن هر نخ برنامه در OpenMP توسط نخهای سختافزاری.

ابزارهای برنامهنویسی سیستمهای دارای حافظه توزیعیافته

رابط عبور پیام

متداولترین شیوه برنامهنویسی موازی استفاده از MPI میباشد. رابط عبور پیام، ویژگیهای یک واسط برنامه نویسی کاربردی کلی برای برنامهنویسی موازی را برای سیستمهای دارای حافظه توزیعیافته مانند کلاسترهای تیغهای و مجموعه آنها تعیین میکند و به خودی خود یک ابزار نیست، بلکه یک طرح ویژگیها (به انگلیسی: Specification) و یک پروتکل ارتباطی به شمار میرود و همانگونه که از نامش پیداست، شیوه صحبت کردن سیستمهای موازی با هم را تعیین میکنند. مهمترین مزیت روش رابط عبور پیام به سایر روشهای عبور پیام، قابل حمل بودن و سرعت بالای آن میباشد. سرعت بالای این روش به این دلیل است که هنگام اجرا بر روی هر سختافزاری برای آن سختافزار بهینه میشود. مزیت بزرگ دیگر این روش، توانایی فراخوانی توابع آن با زبانهای C++، C، فورترن، جاوا، C# و پایتون میباشد.

زبانهای برنامهنویسی موازی

زبان های برنامه نویسی همزمان، کتابخانه ها، رابط های برنامه کاربردی، و مدل های برنامه نویسی موازی (مانند اسکلت الگوریتمی) برای برنامه نویسی موازی کامپیوترها ایجاد شده است.این به طور کلی به چند کلاس بر مبنای حافظه معماری مشترک ، حافظه توزیع شده و حافظه توزیع شده مشترک تقسیم میشود. زبان های برنامه نویسی حافظه مشترک با دستکاری متغیرهای حافظه مشترک ارتباط برقرار کنید. حافظه توزیع شده از عبور پیام استفاده میکنند.ترد های POSIX و OpenMP هردو بیشتر از رابط های برنامه های کاربردی حافظه مشترک استفاده میکنند،درحالی که رابط عبور پیام (MPI) بیشتر از رابط های برنامه کاربردی سیستم عبور پیام استفاده میکند. [۱]

در کنار رهیافتهایی مانند MPI و OpenMP که قابلیتهای مورد نیاز برای برنامهنویسی موازی با زبانهای شناختهشدهای مانند C و فرترن را فراهم میآورند، شمار قابل توجهی زبان برنامهنویسی مستقل، از اساس برای نوشتن کدهای پردازش موازی ایجاد شدهاند.

لیندا

لیندا به دستهای از زبانهای برنامهنویسی موازی تعلق دارد که در آنها تقسیم کارهای درون برنامه به رشتهها و فرستادن رشتهها به پردازندهها باید به طور صریح در متن کد مشخص شود، اما ارتباط میان رشتههای ایجادشده بر عهده برنامهنویس نیست.

لیندا به خودی خود یک زبان قابل استفاده مستقیم نیست و به اصطلاح یک زبان هماهنگسازی (به انگلیسی: Coordination) خوانده میشود. پیادهسازیهایی از آن برای بسیاری از زبانهای برنامهنویسی و اسکریپتنویسی متداول، از جمله جاوا، C و C++، پایتون و روبی ارائه شدهاست. خصلت اصلی لیندا آن است که به جای مدل ارتباط نقطه به نقطه که در بیشتر رهیافتهای برنامهنویسی موازی دنبال میشود، مفهومی به نام فضای چندگانه (به انگلیسی: tuple space) را ارائه میکند که بستر اصلی موازیسازی در مدل این زبان است. فضای چندگانه یک مخزن عمومی دادهها است که دادهها را میتوان در آن ذخیره و سپس از آن بازیابی کرد.[۲]

ارلنگ

ارلنگ یک زبان زمان اجرا است که از ابتدا با هدف مستقیم ایجاد برنامههای موازی بیدرنگ با آستانه تحمل خطای بالا و تا حد زیادی با در نظر داشتن سیستمهای مخابراتی نوشتهشدهاست. ارتباط میان پردازشها در ارلنگ صریح است و همانند OpenMP باید توسط برنامهنویس تعیین شود، اما بر خلافOpenMP، ارلنگ از تبادل پیام برای ارتباط میان روندها استفاده میشود. ارلنگ زبانی مبتنی بر تابعها است، به این مفهوم که پردازش دادهها در یک برنامه ارلنگ در قالب محاسبه تابعهای ریاضی صورت میپذیرد و تقریباً همه چیز با تعریف کردن تابعها انجام میشود. موازیسازی پردازش در ارلنگ با تعریف کردن روندهایی که اشتراکی با هم ندارند، انجام میشود. ارتباط میان این روندها توسط یک سیستم تبادل پیام ناهمگام انجام میشود.[۲]

چارم++

چارم++، زبانی مبتنی بر C++ است که با هدف آسان کردن برنامهنویسی موازی و با ارائه قابلیتهای برنامهنویسی موازی در سطح بالایی از انتزاع ارائه شده است. مبنای موازیسازی برنامه در چارم++، بر تجزیهکردن برنامه به شماری شیء به نام Chare است. Chareها با یکدیگر تعامل دارند و به پیامها وابسته هستند. Chareها در زمان اجرای برنامه با یک سیستم زمان اجرای پویا به پردازندههای مختلف متناظر میشوند که چارم++، امکان تغییر دادن این تناظر هنگام اجرای برنامه را فراهم میآورد. چنین امکانی برای متعادل کردن بار پردازشی روی پردازندهها در زمان اجرا مفید است. امکان برنامهنویسی با شیوهای مبتنی بر رابط عبوری پیام، نیز با ارائه یک پیادهسازی از آن به نام رابط عبوری تطبیقی پیام به اختصار AMPI در لایهای روی چارم++، فراهم شده است.[۲]

Unified Parallel C

زبانی بر پایه C99 است که قابلیتهای آن را برای برنامهنویسی موازی برای سیستمهای دارای حافظه اشتراکی یا توزیعیافته گسترش میدهد. مبنای برنامهنویسی در UPC بر پایه اشتراک داده میان پردازندههای مختلف است، به گونهای که همه پردازندهها به تمام متغیرها در برنامه دسترسی دارند، اما هر متغیر در اصل به یک پردازنده مشخص تعلق دارد. موازیسازی برنامه هنگام آغاز اجرا شدن آن تعیین میشود و در طول اجرا تغییر نمیکند، زیرا تناظر میان متغیرها با پردازندهها را در میانه اجرای برنامه نمیتوان تغییر داد. برای نوشتن برنامههای پردازش موازی به اینگونه، UPC چهار دسته ساختار به ابزارهای عادی C میافزاید:

- یک مدل صریح اجرای موازی.

- فضای حافظه اشتراکی.

- شیوههایی برای همگامسازی متغیرها

- مدلی برای بررسی سازگاری درونی حافظه اشتراکی و شیوههایی برای مدیریت حافظه.[۲]

کاربرد های پردازش موازی

پیش بینی وضعیت اب و هوایی : استفاده از مدل های ریاضی از اقیانوس و جو و گرفتن مشاهدات فعلی آب و هوا و پردازش این داده ها با مدل های کامپیوتری برای پیش بینی وضعیت آینده آب و هوا.

مسائل اقتصادی جامعه : پردازش موازی برای مدل سازی اقتصاد یک جهان یا ملت استفاده می شود. سیستم برنامه ها که شامل دستگاه های محاسبه خوشه ای هستند ، برای پیاده سازی الگوریتم های موازی در راستای بهینه سازی در چنین مدل های اقتصادی استفاده می شود.

هوش مصنوعی و اتوماسیون : هوش مصنوعی یا هوش ماشینی (به انگلیسی: Artificial Intelligence)هوشی که یک ماشین در شرایط مختلف از خود نشان میدهد، گفته میشود.که در این سیستم ها تا حد زیادی از پردازش موازی استفاده میشود.به عنوان مثال در 4 عمل 1)پردازش تصویر 2)پردازش زبان های طبیعی 3)تشحخیص الگوها 4)سیستم های خبره ف پردازش موازی کاربرد دارد.

نرمافزار پزشکی: پردازش موازی در پردازش تصویر پزشکی استفاده می شود.به عنوان مثال برای اسکن بدن انسان و اسکن مغز انسان ، در بازسازی MRI برای تشخیص مهره ها استفاده میشود.

منبع : ویکی پدیا

مطالب مرتبط:

← اجاره ابر رایانه →