بهترین سرور محاسباتی برای هوش مصنوعی در ۲۰۲۵: راهنمای کامل و مقایسه

هوش مصنوعی (AI) و یادگیری عمیق (Deep Learning) نیازمند توان پردازشی بسیار بالایی هستند، انتخاب سرور مناسب میتواند تفاوت بین آموزش مدلها در چند روز یا چند هفته را رقم بزند. در این راهنمای جامع ، با معیارهای فنی، مقایسه بهترین گزینه ها و نکات کلیدی خرید سرور آشنا خواهید شد.

فهرست مطالب

- چرا به سرور محاسباتی قدرتمند نیاز داریم؟

- معیار های کلیدی در انتخاب سرور AI

- مقایسه بهترین سرور های محاسباتی برای هوش مصنوعی

- 3.1. Nvidia DGX A100

- 3.2. Google Cloud TPU v5

- 3.3. AWS EC2 P4d

- 3.4. سرورهای اختصاصی GPU (مثلاً Lambda Labs)

- GPU، CPU، حافظه و شبکه : چه چیزهایی مهم است؟

- سرور ابری یا اختصاصی؛ کدام بهتر است ؟

- نکات پایانی و راهنمای خرید

- سوالات متداول ( FAQ )

چرا به سرور محاسباتی قدرتمند نیاز داریم؟

- حجم دادهها : پروژههای یادگیری عمیق معمولاً از چند صد گیگابایت تا دهها ترابایت داده استفاده میکنند.

- مدلهای بزرگ: معماریهای مدرن مثل GPT، BERT و Vision Transformer دارای صد ها میلیون تا میلیارد ها پارامتر هستند

- زمان آموزش: با سرورهای ضعیف، آموزش یک مدل NLP ساده میتواند هفته ها طول بکشد که از نظر اقتصادی و زمانی اصلا به صرفه نیست .

معیارهای کلیدی در انتخاب سرور AI

- GPU یا TPU

- تعداد هستههای CUDA (برای Nvidia) یا TPU

- حافظه VRAM حداقل ۳۲ – ۴۰ گیگابایت

- پردازنده (CPU)

- حداقل ۱۲–۱۶ هسته فیزیکی

- معماری مدرن (Intel Xeon یا AMD EPYC)

- حافظه اصلی (RAM)

- حداقل ۱–۲ ترابایت برای دادههای بزرگ

- سرعت و پهنای باند دیسک

- SSD NVMe با سرعت خواندن/نوشتن بالا

- امکان استفاده از RAID برای افزونگی

- شبکه (Networking)

- اینتر کانکت های ۴۰–۱۰۰ گیگابیتی برای خوشههای توزیع شده

- قابلیت مقیاسپذیری

- پشتیبانی از k8s، SLURM یا سیستمهای مدیریت خوشه

- پشتیبانی و سرویسدهی

- سرویس SLA، مانیتورینگ، به روزرسانی درایورها و فریمورک ها

مقایسه بهترین سرورهای محاسباتی برای هوش مصنوعی

| سرور | پردازندههای گرافیکی | حافظه اصلی | شبکه | قیمت تقریبی |

|---|---|---|---|---|

| Nvidia DGX A100 | ۸× Nvidia A100 (۶۴ گیگابایت VRAM) | ۱٫۵ ترابایت | اینترکانکت NVLink | ~$200,000 |

| Google Cloud TPU v5 | ۴–۸ TPU v5 | مدیریتشده | شبکه گوگل داخلی | از $32/ساعت |

| AWS EC2 P4d | ۸× Nvidia A100 | ۱٫۲ ترابایت | ENA 400Gbps | از $32.77/ساعت |

| Lambda Labs GPU Servers | ۴× RTX 6000 Ada (۴۸ گیگابایت VRAM) | ۵۱۲ گیگابایت | ۱۰–۴۰Gbps | ~$20,000–$40,000 |

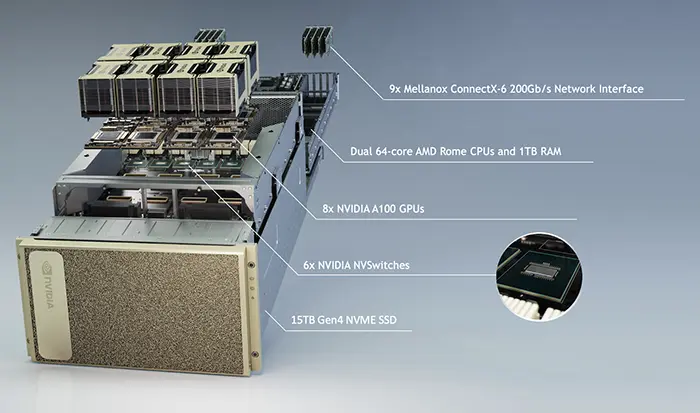

3.1. Nvidia DGX A100

– ویژگیها: ۸ کارت A100 ، حافظه ۶۴ گیگابایتی هر کارت، اینترکانکت NVLink با سرعت فوقالعاده

– مناسب برای: مراکز تحقیقاتی و سازمانهای بزرگ با بودجهی سنگین.

3.2. Google Cloud TPU v5

– ویژگیها : واحدهای TPU کاملاً مدیریت شده، یکپارچگی با اکوسیستم TensorFlow.

– مناسب برای : کاربرانی که زیر ساخت on-premise ندارند و بهدنبال انعطافپذیری ابری هستند

3.3. AWS EC2 P4d

– ویژگیها : ۸ کارت A100، شبکه پرسرعت ۴۰۰Gbps، ذخیره سازی انعطافپذیر.

– مناسب برای: تیمهای توسعه و استارتآپهای AI که نیاز به مقیاسپذیری سریع دارند .

3.4. سرورهای اختصاصی GPU (مثلاً Lambda Labs)

– ویژگیها: کانفیگهای متنوع از ۴ تا ۱۶ کارت، قیمت رقابتی، پشتیبانی تخصصی

– مناسب برای : توسعه دهندگان مستقل و شرکتهای میانی که به دنبال هزینه کمتر و سختافزار قابل ارتقا هستند

GPU، CPU، حافظه و شبکه: چه چیزهایی مهم است؟

- GPU: هسته های CUDA/Tensor، حافظه VRAM

- CPU: تعداد هسته ها و فرکانس و توان مصرفی

- حافظه (RAM): ظرفیت و عدد کانالها ( مثلاً ۸×64GB DDR4)

- شبکه: تأخیر (Latency ) و پهنای باند ( Bandwidth) برای آموزش توزیعشده.

نکته: بهبود عملکرد مدلهای بزرگ بیشتر وابسته به GPU و شبکه پرسرعت است تا CPU

سرور ابری یا اختصاصی؛ کدام بهتر است؟

| معیار | سرور ابری | سرور اختصاصی |

|---|---|---|

| هزینه پیشپرداخت | صفر یا حداقل | بالا |

| مقیاسپذیری | بسیار آسان (افزایش/کاهش بر حسب نیاز) | نیاز به خرید و نصب سخت افزار |

| نگهداری و بهروزرسانی | توسط ارائهدهنده ابری انجام میشود | نیاز به تیم فنی داخلی |

| سفارشیسازی سختافزار | محدود | کاملاً ممکن |

نکات پایانی و راهنمای خرید

- بودجه خود را مشخص کنید: هزینه خرید در مقابل هزینه ساعتی ابری را مقایسه کنید

- نوع پروژه را در نظر بگیرید : آموزش یکباره مدل بزرگ یا استقرار مداوم inference.

- پشتیبانی فنی: SLA و خدمات پس از فروش برای اطمینان از آپتایم سرور

- مقیاسپذیری: اگر رشد پروژه برایتان مهم است، گزینه ابری یا خوشه بندی را انتخاب کنید.

سوالات متداول (FAQ)

۱. بهترین GPU برای یادگیری عمیق چیست؟

در حال حاضر Nvidia A100 با ۶۴ گیگابایت حافظه VRAM و هستههای Tensor قدرتمند، گزینه ی طلایی برای پروژههای AI است.

۲. آیا میتوانم از کارتهای مصرفی مثل RTX 4090 استفاده کنم؟

بله؛ برای پروژههای پژوهشی و توسعه کوچک مناسب است، اما برای آموزش مدلهای بزرگ و توزیعشده، سرورهای حرفهای با اینترکانکت NVLink بهتر عمل میکنند

۳. هزینهی استفاده از TPU در گوگل چقدر است؟

قیمت TPU v5 از حدود ۳۲ دلار در ساعت شروع میشود و بسته به منطقه و تعهد مصرف ، امکان تخفیف نیز وجود دارد.

با رعایت معیار ها و نکات فوق، میتوانید بهترین سرور محاسباتی متناسب با نیازهای هوش مصنوعی خود را انتخاب کرده و زمان و هزینه آموزش مدلها را به صورت چشمگیری کاهش دهید.

کلمات مرتبط:

سرور محاسباتی هوش مصنوعی، بهترین سرور برای هوش مصنوعی، سرور GPU برای AI، سرور یادگیری ماشین، سرور deep learning ، سرور NVIDIA A100، سرور DGX A100، سرور Google TPU، سرور AWS برای هوش مصنوعی، سرور ابری برای AI، GPU مناسب برای یادگیری عمیق، مقایسه سرورهای هوش مصنوعی، سرور مناسب برای دیتا ساینس، سرور RTX برای یادگیری عمیق، سرور Lambda Labs

مقاله مادر:

دیدگاه خود را ثبت کنید

تمایل دارید در گفتگوها شرکت کنید؟در گفتگو ها شرکت کنید.