اجاره سرور محاسباتی برای تحقیقات دانشگاهی

در این مقاله یاد می گیرید چرا اجاره سرور محاسباتی برای پژوهشهای دانشگاهی مقرون به صرفه و کاربردی است ، چه معیار هایی را برای انتخاب سرور باید در نظر بگیرید و چگونه هزینه ها و دشواری های این کار را به حداقل برسانید

فهرست مطالب

- چرا پژوهشگران به سرور محاسباتی نیاز دارند؟

- مزایای اجاره سرور محاسباتی چیست

- کاربردها در رشته های مختلف

- ویژگی های فنی و معیارهای انتخاب سرور

- مدلهای قیمتی و بودجه بندی

- نکات راه اندازی و نرمافزاری

- امنیت و پشتیبان گیری

- پرسشهای متداول

- نتیجهگیری و منابع

چرا پژوهشگران به سرور محاسباتی نیاز دارند؟

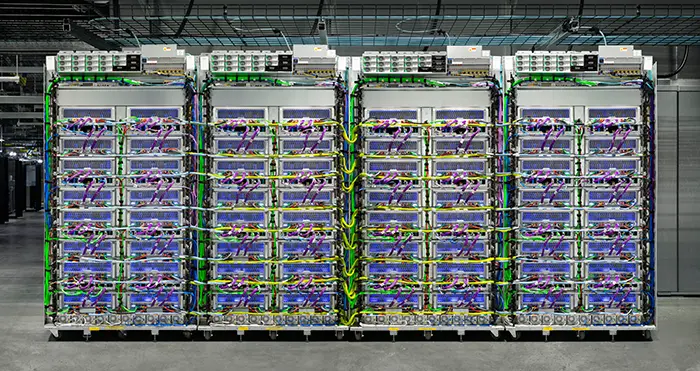

پژوهش های مدرن در بسیاری از رشته ها — از مهندسی و علوم کامپیوتر تا زیست فناوری و اقتصاد — به پردازش سریع داده ها، شبیه سازیهای پیچیده و آموزش مدل های یادگیری ماشین نیاز دارند و این وظایف اغلب از توان کامپیوترهای معمولی فراتر میروند و اجرای آنها روی سرورهای قوی یا خوشه های محاسباتی (HPC) زمان اجرای پروژه را به شدت کاهش میدهد.

مثالهای ملموس

شبیهسازیهای CFD که روی کامپیوتر خانگی دسکتاپ زمان بر است، تحلیل توالیهای ژنتیکی چند ترابایتی ، یا آموزش یک شبکهٔ عصبی عمیق با میلیونها پارامتر تنها با دسترسی به سرورهای مجهز به GPU و حافظهٔ بالا قابل انجام با بازده مناسب هستند

مزایای اجاره سرور محاسباتی

صرفهجویی هزینه

پرداخت متناسب با استفاده

دسترسی به سختافزار قوی

استفاده از نسلهای اخیر CPU/GPU

مقیاسپذیری

افزایش منابع در زمان نیاز

پشتیبانی و نگهداری

بدون دردسر نگهداری فیزیکی

اجارهٔ سرور محاسباتی به پژوهشگران این اجازه میدهد که بدون سرمایهگذاری کلان به منابع پیشرفته دسترسی پیدا کنند. علاوه بر این ، بعضی از فراهم کنندگان خدمات، ابزارهایی برای مدیریت آسان وظایف ، صف بندی شبیه سازیها و زمانبندی اجرای پروژه ها ارائه میکنند.

کاربردها در رشته های مختلف

مهندسی

شبیه سازیهای المان محدود (FEA) ، دینامیک سیالات محاسباتی (CFD) و بهینه سازی پارامتری با استفاده از نرم افزارهایی مانند Abaqus، ANSYS و COMSOL

علوم زیستی و بیوانفورماتیک

تحلیل ژنوم ، توالییابی نسل جدید (NGS)، تحلیل داده های پروتئومی و شبیهسازیهای مولکولی که نیازمند پردازش موازی هستند.

علوم داده و هوش مصنوعی

آموزش مدلهای یادگیری عمیق، پردازش زبان طبیعی، تحلیل داده های بزرگ و آزمون سریع الگوریتمهای جدید

فیزیک، شیمی و علوم پایه

محاسبات کوانتومی شبیه سازیشده ، دینامیک مولکولی و تحلیلهای عددی با دقت بالا .

ویژگیهای فنی و معیارهای انتخاب سرور

انتخاب سرور مناسب وابسته به نوع پروژه و نیازهای تحقیقاتی است . در ادامه مواردی که باید بررسی کنید آمده است:

پردازنده (CPU)

برای بارهای کاری متکی بر سریال یا چند رشته ای (multi-threaded)، پردازندههای چند هستهای مانند Intel Xeon یا AMD EPYC توصیه میشوند. تعداد هسته و فرکانس مناسب را با توجه به نرمافزار هدف انتخاب کنید.

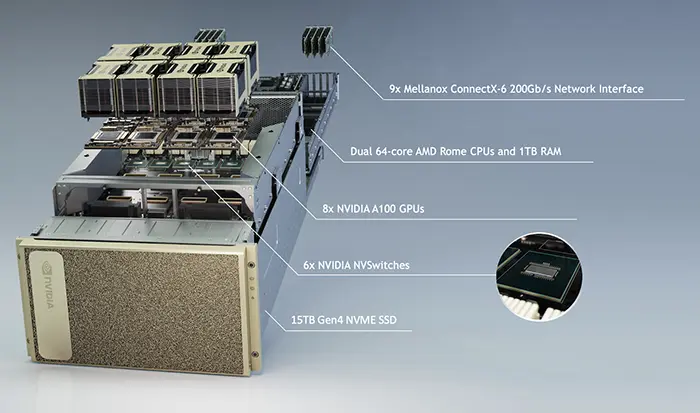

کارت گرافیک (GPU)

اگر پروژه شامل یادگیری ماشین یا تسریع محاسبات موازی است، وجود GPU با VRAM بالا (مثلاً 16GB به بالا برای پروژههای Deep Learning متوسط و 40GB+ برای پروژههای بزرگ ) حیاتی است. مدلهایی مانند NVIDIA A100، H100 یا سری RTX برای شما مناسب اند

حافظه رم و ذخیرهسازی (هارد)

حداقل 64GB RAM برای بسیاری از پروژه های پژوهشی توصیه میشود؛ اما برخی پروژهها نیازمند چند صد گیگ حافظه هستند. استفاده از هارد NVMe/SSD سرعت I/O را افزایش میدهد و زمان بارگذاری داده را کاهش میدهد.

شبکه و پهنای باند

برای پروژه هایی که دادهها از منابع خارجی ( مثل دیتاسِتهای عظیم یا پایگاهداده دور) خوانده میشوند، اتصال شبکهٔ پرسرعت و پهنای باند بالا ضروری است. در خوشه های مقیاس پذیر، شبکهٔ داخلی با تاخیر کم نیز اهمیت دارد.

سازگاری نرم افزاری

اطمینان حاصل کنید که سرور از محیطهای برنامه نویسی و کتابخانههای مورد نیاز شما پشتیبانی میکند: Python, R, MATLAB, CUDA, cuDNN, TensorFlow, PyTorch و بستههای تخصصی حوزهٔ تحقیق

مدلهای قیمتی و بودجهبندی

ارائهدهندگان سرویس معمولاً مدلهای قیمتی زیر را ارائه میدهند:

- ساعتمحور: پرداخت بر اساس ساعت استفاده؛ مناسب پروژههای کوتاهمدت.

- ماهمحور: قراردادهای ثابت ماهیانه؛ مناسب پروژههای طولانی.

- پلنهای حجمی: برای مؤسسات یا گروههایی که مصرف بالایی دارند، تخفیفهای حجمی اعمال میشود.

نکات بودجهبندی : هزینهٔ ذخیرهسازی بلندمدت، انتقال داده (اینترنت مصرفی)، لایسنس نرمافزار و پشتیبانی فنی را در برآورد خود لحاظ کنید.

نکات راهاندازی و نرمافزاری

نصب و مدیریت محیط

از مدیریت بستهها (Conda, pip, apt) و ابزارهای کانتینرسازی (Docker, Singularity) برای تضمین تکرار پذیری محیط تحقیقاتی استفاده کنید. کانتینرها به شما اجازه میدهند که محیط توسعه ی محلی را به سرور منتقل کنید بدون اینکه مشکلات وابستگی پیش بیاید .

صفبندی و زمانبندی وظایف

برای استفادهٔ بهینه از منابع در خوشهها از سامانههای صفبندی مانند Slurm یا PBS استفاده کنید. این ابزارها امکان اجرای موازی، اولویت بندی و مدیریت منابع را فراهم میکنند

نکات مربوط به لایسنسها

اگر از نرمافزارهای غیررایگان مانند MATLAB یا ANSYS استفاده میکنید، مطمئن شوید که ارائه دهندهٔ سرور پشتیبانی لایسنس شبکهای را دارد یا راهکاری برای استفادهٔ قانونی ارائه میدهد.

امنیت و پشتیبانگیری

امنیت داده به ویژه در پروژههای حاوی اطلاعات حساس (مثل دادههای بالینی) اهمیت بالایی دارد. نکات ضروری:

- رمزنگاری دادهها هنگام انتقال و در حالت ذخیرهسازی (TLS و AES-256 یا معادل).

- دسترسی بر پایهٔ نقش (RBAC) و استفاده از کلیدهای SSH بهجای رمز عبور .

- انجام پشتیبان گیری منظم و تست بازیابی (backup & DR)

- مانیتورینگ، لاگ گیری و آلارم برای تشخیص نفوذ یا مشکلات عملکردی.

پرسشهای متداول

چقدر رم و GPU برای پایاننامهٔ دکتری نیاز دارم؟

پاسخ بستگی به حوزهٔ پژوهش دارد؛ اما به طور کلی برای مدل های یادگیری عمیق متوسط، حداقل یک GPU با 16-24GB VRAM و حداقل 64GB رم پیشنهاد میشود. پروژههای بزرگتر ممکن است نیازمند GPUهای 40GB+ و رم بالاتر باشند.

آیا میتوانم دادههایم را بهصورت امن روی سرور اجارهای نگه دارم؟

در صورتی که ارائه دهنده استانداردهای امنیتی را رعایت کند. از قراردادهای حفظ حریم خصوصی، رمزنگاری و پشتیبانگیری منظم اطمینان حاصل کنید.

آیا امکان اجرای نرمافزارهای دارای لایسنس وجود دارد؟

بسیاری از ارائه دهندگان راهکارهایی برای مدیریت لایسنس نرم افزاری ارائه میدهند ؛ پیش از اجاره در مورد پشتیبانی لایسنس سؤال کنید.

نتیجهگیری و گامهای بعدی

اجارهٔ سرور محاسباتی برای تحقیقات دانشگاهی نه تنها هزینههای اولیه را کاهش میدهد بلکه دسترسی سریع و امن به منابع پیشرفته را فراهم میآورد. برای شروع:

- نیازهای محاسباتی پروژه را مشخص کنید (CPU, GPU, RAM, storage).

- بودجه و مدل قیمتی مناسب را انتخاب کنید (روزانه هفتگی ماهانه).

- پرسشهای امنیت و لایسنسها را قبل از قرارداد بررسی کنید.

- محیط نرمافزاری و کانتینرها را آماده کنید تا انتقال به سرور ساده باشد.